Nvidia alcanzó ingresos por US$ 51.200 millones en el último trimestre, lo que significó un incremento del 66% frente al mismo período del año pasado. El director ejecutivo, Jensen Huang, destacó que la demanda por los chips Blackwell fue extraordinaria y confirmó que las GPU para servicios en la nube ya se agotaron. En este contexto, la empresa proyecta ingresos por US$ 65.000 millones para el próximo trimestre.

En paralelo, en Memphis, xAI, la compañía de Elon Musk, construye Colossus 2, que será el clúster de entrenamiento de inteligencia artificial más grande del mundo. Una vez terminado, en 2026, alojará más de 500.000 GPU Nvidia. En esta etapa inicial ya se están instalando los primeros 110.000 chips.

Los números detrás del dominio

La escala impresiona. Nvidia representa hoy cerca del 8% de la ponderación total del S&P 500, el nivel de concentración más alto para una sola acción en más de medio siglo. La empresa cobra unos US$ 3 millones por cada rack con 72 GPU Blackwell y despacha cerca de 1.000 racks por semana.

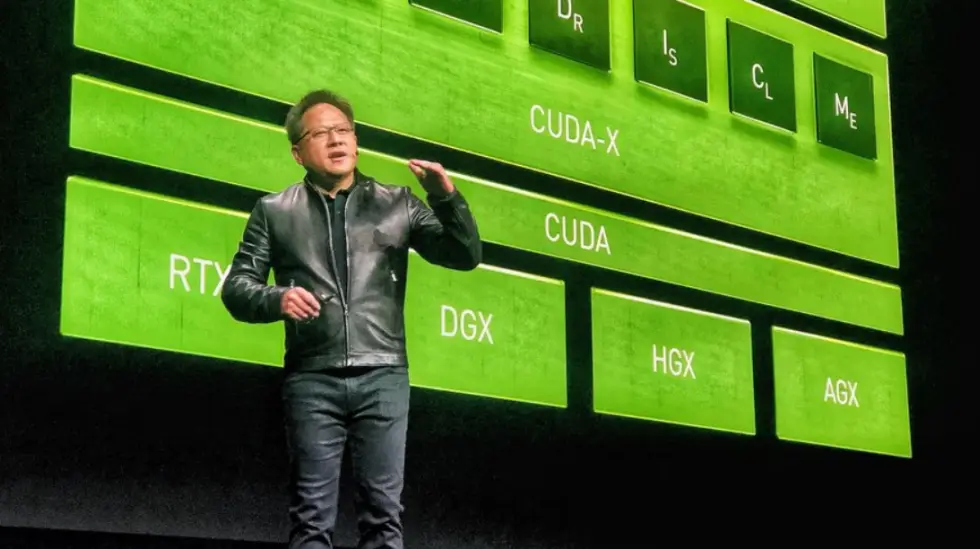

En marzo, durante la GTC, Huang corrió el foco de los chips hacia lo que él denomina "fábricas de IA": espacios informáticos diseñados para procesar grandes volúmenes de datos y crear sistemas de inteligencia artificial. Cada rack GB200 NVL72 integra más de 600.000 componentes y actúa como una única computadora de gran escala, con un rendimiento 30 veces superior al de generaciones anteriores cuando se trata de modelos de IA con billones de parámetros.

La complejidad como ventaja competitiva

No se trata de servidores que puedan armarse con componentes estándar. Estos sistemas exigen ingeniería de precisión: cada rack necesita refrigeración líquida con un consumo de 120 kilovatios, interconexiones personalizadas que alcanzan los 130 terabytes por segundo entre GPU y un software capaz de operar decenas de miles de chips como si fueran una sola máquina.

Por qué los chips personalizados todavía no achicaron la distancia

En los papeles, la nueva TPU Ironwood de Google parece estar a la altura. Cada chip ofrece 4,6 petaFLOPS de potencia para computación de inteligencia artificial, apenas por encima de los 4,5 petaFLOPS que alcanza el B200 de Nvidia. Google puede escalar este hardware en módulos de 9.216 chips, con una capacidad teórica para integrar 400.000 aceleradores en un solo clúster.

Pero hay un problema: las TPU solo funcionan dentro de Google Cloud. Si alguien quiere ejecutar cargas de trabajo en distintos proveedores de nube, montar infraestructura propia o usar frameworks fuera del ecosistema de Google, Nvidia sigue siendo la única alternativa.

Los chips Trainium de Amazon enfrentan trabas similares. AWS asegura ofrecer una relación precio-rendimiento entre un 30% y un 40% superior a la de otros proveedores, aunque solo en cargas que se ejecutan íntegramente en su nube. Estos chips están diseñados para tareas específicas, a diferencia de la flexibilidad de propósito general que tiene el hardware de Nvidia, capaz de manejar entrenamiento, ajuste e inferencia en cualquier entorno.

Para una empresa que invierte US$ 100.000 millones en infraestructura que debe estar funcionando en dos años, depender del hardware propietario de un único proveedor de nube representa un riesgo que la mayoría prefiere evitar.

La verdadera barrera: el ecosistema

La ventaja de Nvidia no está solo en el silicio. Son décadas de desarrollo de software, herramientas y equipos de ingenieros capacitados.

CUDA, la plataforma de programación que Nvidia empezó a construir en 2006, ejecuta casi todos los principales frameworks de inteligencia artificial, como PyTorch, TensorFlow y JAX. Pasarse a un chip de la competencia suele implicar reescribir el código, capacitar al personal y asumir que algunas funciones simplemente no van a estar disponibles.

Las búsquedas laborales que mencionan "CUDA" siguen superando por mucho a las que nombran alternativas. Cuando el curso de aprendizaje automático de Stanford incorporó en 2025 al framework JAX de Google como opción predeterminada, llamó la atención justamente porque CUDA fue el estándar durante más de diez años.

Nvidia también construyó vínculos a lo largo de toda la cadena de suministro. La empresa colabora con más de 200 socios tecnológicos en más de 150 fábricas distribuidas por todo el mundo. Compañías eléctricas, expertos en refrigeración, desarrolladores de centros de datos e incluso grandes firmas de inversión forman parte hoy de la red de Nvidia.

Este ecosistema significa que un CEO que elige infraestructura de Nvidia no solo compra chips, sino una estrategia integral con soporte global.

¿Qué podría cambiar?

La economía empieza a moverse en los márgenes. Para cargas de inferencia a gran escala, donde se ejecuta el mismo modelo una y otra vez, las TPU de Google y los chips Trainium de Amazon pueden ofrecer un mejor costo por token que las GPU de propósito general de Nvidia.

Algunas compañías ya comenzaron a hacer el cambio de manera silenciosa. Anthropic se comprometió a incorporar cientos de miles de TPU de Google antes de que termine 2025. Según trascendió, Midjourney trasladó gran parte de su trabajo de generación de imágenes del hardware de Nvidia a las TPU de Google Cloud, lo que permitió una baja considerable en los costos mensuales.

¿Pero entrenar nuevos modelos de última generación? Para eso, todavía se necesita Nvidia. Cuando xAI tuvo que desarrollar el sistema de entrenamiento de inteligencia artificial más potente del mundo, no buscó alternativas. Colossus 2 funciona con chips Nvidia GB200.

La competencia existe: la TPU Ironwood de Google iguala por primera vez a Nvidia en especificaciones puras. La serie MI350 de AMD también aparece como opción para las empresas que quieren contar con un segundo proveedor. Pero alcanzar los mismos números en una prueba de rendimiento no es lo mismo que replicar toda la estructura de software, soporte y cadena de suministro que Nvidia viene construyendo desde hace décadas.

Qué implica esto para los demás

Para los inversores, el mensaje es claro: el dominio de Nvidia no es frágil, pero tampoco está asegurado para siempre. La compañía necesita seguir moviéndose más rápido que sus rivales, que al fin empiezan a ofrecer alternativas con peso propio.

Para las empresas que desarrollan sistemas de inteligencia artificial, la decisión depende del contexto. Si entrenan modelos de última generación o necesitan flexibilidad para operar entre distintas nubes y entornos, Nvidia sigue siendo el estándar. Pero si ejecutan cargas masivas de inferencia dentro de una única nube, vale la pena analizar con cuidado si los chips especializados ofrecen una mejor relación entre costo y rendimiento.

Para el resto, esta expansión de infraestructura también tiene impacto, incluso si no usan inteligencia artificial de forma directa. La energía que alimenta estos centros de datos está empujando las tarifas eléctricas al alza. Las cadenas de suministro que sostienen estas fábricas están cambiando la forma en que se produce a nivel global. La escasez de chips que encareció las notebooks durante la pandemia fue apenas una muestra de lo que pasa cuando la demanda de computación supera la capacidad de oferta.

Nvidia no vende solo hardware. Está construyendo los cimientos de lo que Huang describe como "la era de la IA". Que esa base siga siendo propiedad exclusiva de Nvidia o se abra a una competencia más equilibrada va a ser clave para definir el rumbo tecnológico de la próxima década.

Nota publicada por Forbes US