La IA está en camino de convertirse en una compañera constante, ofreciendo respuestas inmediatas -aunque no siempre correctas- a millones de usuarios, e incluso utilizándola para tomar distintas decisiones. Sin embargo, es precisamente esta ubicuidad y las expectativas que está generando en relación a sus futuras capacidades que el coste de crear un modelo de IA completo es cada vez más alto. Las pocas empresas que ya dominan este sector planean invertir cientos de miles de millones de dólares en los próximos años para mejorar sus modelos y ponerlos al alcance del mayor número de personas posible.

Pese a todo esto, para algunos expertos en tecnología y voces destacadas del ámbito, el hype y la burbuja de la IA no es lo único para temer: para algunos, la IA se encuentra en lo que Cory Doctorow, periodista y autor de ciencia ficción, llama “enshitificación” (que podría traducirse literalmente como “mierdificación”), es decir, es un proceso negativo de empeoramiento.

El término acuñado por Doctorow, que inspiró ensayos muy virales y libros, refiere al fenómeno por el cual Internet comenzó a poblarse de contenido basura producido principalmente por robots, incluyendo publicidad, contenido no relevante o spam, y que alcanza su “peak” en 2025 gracias al uso masivo de la inteligencia artificial. Sin embargo esta teoría es parte de lo que Doctorow describe como un ciclo natural de decadencia de las plataformas digitales, que dicta que, tras captar usuarios ofreciendo un buen servicio, terminan explotando a todos (creadores, vendedores, usuarios) para maximizar ganancias, traicionando aquello que las hacía buenas, singulares o exitosas en un primer momento. Apreciación que en la actualidad ya se está empezando extender a la IA y los asistentes.

Así lo explica Steven Levy, cronista de Wired: “Actualmente diría que la IA se encuentra en lo que se conoce como la fase de “beneficio para el usuario” (“good to the users”). Sin embargo, la presión por recuperar las enormes inversiones de capital será tremenda, especialmente para las empresas con una base de usuarios muy fiel. Estas condiciones, como escribe Doctorow, permiten a las empresas abusar de sus usuarios y clientes empresariales para recuperar todo el valor para sí mismas”.

Publicidad en tu asistente de IA

El primer paso de lo que se conoce como enshitificación de un servicio o plataforma es empezar a llenarlo de publicidad, algo que puede resultar muy molesto y familiar para los usuarios de redes sociales, por ejemplo. De hecho, es algo que ya está sucediendo con las principales empresas de IA. Por ejemplo, Meta, ChatGPT(OpenAi), Gemini y el GoogleAI mode muestran anuncios en base a tus conversaciones con su AI. “A fines de 2025, Meta empezó a usar lo que hablamos con su IA para enviarnos anuncios personalizados en nuestras cuentas de Instagram y Facebook, pero fue transparente al respecto en sus nuevos términos y condiciones”, aclara Irina Sternik, de LadoB, explicando que también puede desactivarse.

“Cuando uno imagina la mercantilización de la IA, lo primero que viene a la mente es la publicidad. La pesadilla es que los modelos de IA hagan recomendaciones basadas en las empresas que pagaron por publicidad”, advertía Levy hace unos meses. De a poco, está sucediendo. “Google presentó a sus anunciantes un nuevo tipo de anuncio que justamente se ubicará en AI Mode su asistente de búsqueda tipo chatbot. ¿Cómo es esto? Lo mismo que sucede hoy con Google y los anuncios patrocinados o bien ubicados sucederá cuando buscamos en su IA un producto para comprar. Los primeros serán los que paguen para ser los primeros”, agrega Sternik.

El CEO de OpenAI, Sam Altman, dijo en una entrevista reciente: “Probablemente haya algún producto publicitario interesante que podamos crear que beneficie al usuario y fortalezca nuestra relación con él”. Con lo cual pronto podrían verse más anuncios pagos en ChatGPT, para displacer de los usuarios. Mientras OpenAI cierra con Walmart para que los clientes de la cadena puedan comprar dentro de la aplicación, la plataforma Perplexity tiene un programa donde los resultados patrocinados aparecen en páginas de seguimiento claramente identificadas bajo la promesa de que los anuncios no cambiarán su compromiso de mantener un servicio confiable e imparciales.

¿Qué más podría empeorar el servicio de los asistentes?

Pero incluir anuncios en conversaciones de chatbots o en resultados de búsqueda no es la única forma en que la IA puede volverse un servicio cada vez más “enshitificado”, es decir, un engorro para los clientes pero un bien preciado para las compañías. Doctorow cita ejemplos de empresas que, una vez que dominan un mercado, cambian su modelo de negocio y sus tarifas. Un caso es Amazon, que comenzó siendo un servicio sin publicidad y luego creó distintos niveles de servicio a los que se puede acceder para evitarla. En YouTube pasa algo parecido.

Según la premisa inicial de Doctorow, “una vez que una empresa puede enshitificar sus productos, se enfrentará a la tentación de enshitificar sus productos”, por lo que todo puede y tiende a empeorar siempre. ¿Podría ser una práctica habitual de las grandes tecnológicas fidelizar a los usuarios a un servicio y luego cobrarles tarifas cada vez más altas? Seguramente. También puede pasar que las empresas que antes prometían que tus conversaciones no se usarían para entrenar modelos futuros cambien de opinión.

El propio Doctorow plantea que la IA todavía ni siquiera se encuentra en la etapa “beneficio para los usuarios”, si bien es posible que el proceso de enshitificación ocurra de todos modos, y esto básicamente se debe a su opacidad y las “cajas negras” de los LLM: “Tienen la capacidad de disfrazar su enshitificación de tal manera que les permite salirse con la suya en muchísimas ocasiones, y si la pésima situación económica del sector exige que las empresas no puedan permitirse el lujo de esperar y que se enshitifiquen incluso antes de ofrecer valor, intentarán cualquier estrategia desesperada mientras la situación económica se desploma”.

¿Acaso la reciente avanzada del contenido adulto en algunos de los LLMs como, precisamente, OpenAI, no es una señal? Sobre todo teniendo en cuenta que el propio Altman había negado inicialmente la posibilidad de tener opciones de contenido erótico en la plataforma. A medida que empresas como OpenAI se vuelven más poderosas y tratan de recuperar el dinero de sus inversores, ¿será la IA más propensa a la erosión del valor en las aplicaciones tecnológicas que usamos hoy?

¿Qué más podría empeorar el servicio de los asistentes?

Al mismo tiempo que se está viendo cómo algunas de las grandes empresas tecnológicas están “arruinando” el producto, también comienzan a aparecer analistas que hablan de los límites de crecimiento técnico de la IA. ¿Está llegando a un punto de estancamiento? En un ensayo del New Yorker titulado “¿Qué pasaría si la IA no fuera mucho mejor que esto?”, el profesor de informática y autor Cal Newport cuenta que gran parte de la euforia en torno a las tecnologías de IA se remontan a un paper del 2020 publicado por OpenAI y titulado “Leyes de escalamiento para modelos de lenguaje neuronal”. El paper investigaba el rendimiento de los modelos de lenguaje cuando aumenta su tamaño y la intensidad de su entrenamiento.

“Muchos expertos en aprendizaje automático creían que, tras alcanzar cierto tamaño, los modelos lingüísticos mejorarían a medida que crecieran y que esas mejoras podrían seguir una ley de potencia: una curva agresiva similar a un palo de hockey. Si se siguen construyendo modelos lingüísticos más grandes y se entrenan con conjuntos de datos más grandes, empezarán a mejorar de forma sorprendente”, añade..

Sin embargo, luego de ChatGPT4 los resultados empezaron a mostrarse más lentos, y medios como TechCrunch, según cuenta Newport, empezaron a relativizar estas premisas “exageradas”. “Ahora todo el mundo parece admitir que no se puede simplemente usar más cómputo y más datos mientras se pre entrenan grandes modelos de lenguaje y esperar que se conviertan en una especie de dios digital omnisciente”, publicaban. Pero resultó difícil competir con los titulares que donde Altman y Mark Zuckerberg afirmaban que sus empresas estaban cerca de desarrollar “superinteligencia”.

La decepción con el lanzamiento de GPT5, los reportes cada vez más recurrentes de fallas, sesgos (sycophancy) y problemas alucinatorios, el hecho de que se empezara a hablar más de “post-training” de las inteligencias, en un contexto de hype excesivo, problemas regulatorios, ambientales y de explotación laboral, ayudaron a relativizar este tecno-optimismo.

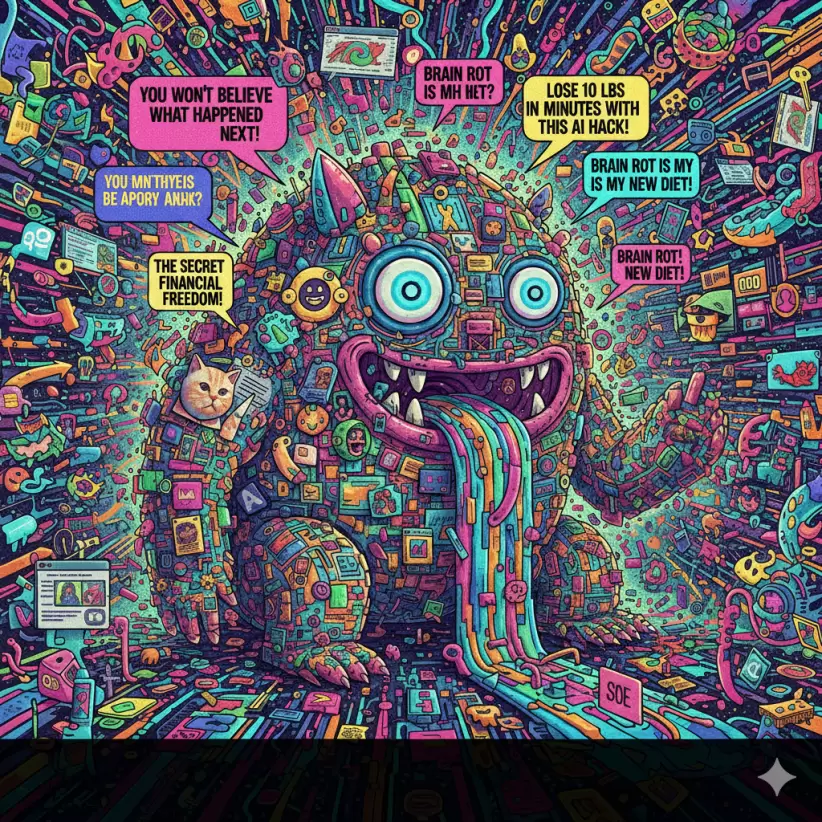

¿Qué pasa cuando los modelos empiezan a tener “brainrot”?

De hecho, el slop o basura sintética generada por la IA ya está generando grandes problemas no solo para el mercado laboral -con estudios recientes diciendo que no mejora la productividad y hablando de work slop AI- pero también con el entrenamiento de los propios modelos.

Resulta que los modelos de AI también pueden tener “brainrot” como los humanos, precisamente porque el éxito de sus respuestas depende de la calidad de la información con la que se lo entrena -los libros y los artículos periodísticos escritos por humanos son una de las fuentes más codiciadas (y las publicaciones en blogs y redes sociales, las menos). Pero, ¿qué pasa cuando más del 50% de los artículos en la web son generados por IA? Es la propia IA la que, al empeorar la experiencia en la web, también está dañando su producto. A medida que las empresas de IA canibalizan los contenidos de calidad de la web y perjudican a creadores y autores, sus propios chatbots y buscadores comenzarán a fallar cada vez más seguido o a ofrecer información de mala calidad. Como un perro que muerde su propia cola.